В быстро меняющемся цифровом ландшафте, где искусственный интеллект все активнее влияет на поиск информации, появляется новая стратегия продвижения – посев контента для больших языковых моделей. Если раньше мы оптимизировали сайты под Google и Яндекс, то теперь нужно думать о том, как попасть в ответы ChatGPT, Gemini и других ИИ-систем.

В этой статье мы детально разберем, что такое LLM, как они выбирают источники информации и какие стратегии помогут вашему контенту попасть в их базы знаний. Вы узнаете не только теорию, но и конкретные шаги для успешного посева контента – от выбора платформ до создания материалов, которые с большей вероятностью попадут в ответы ИИ.

Введение в большие языковые модели (LLM) и посев контента

Руководство по LLM для начинающих

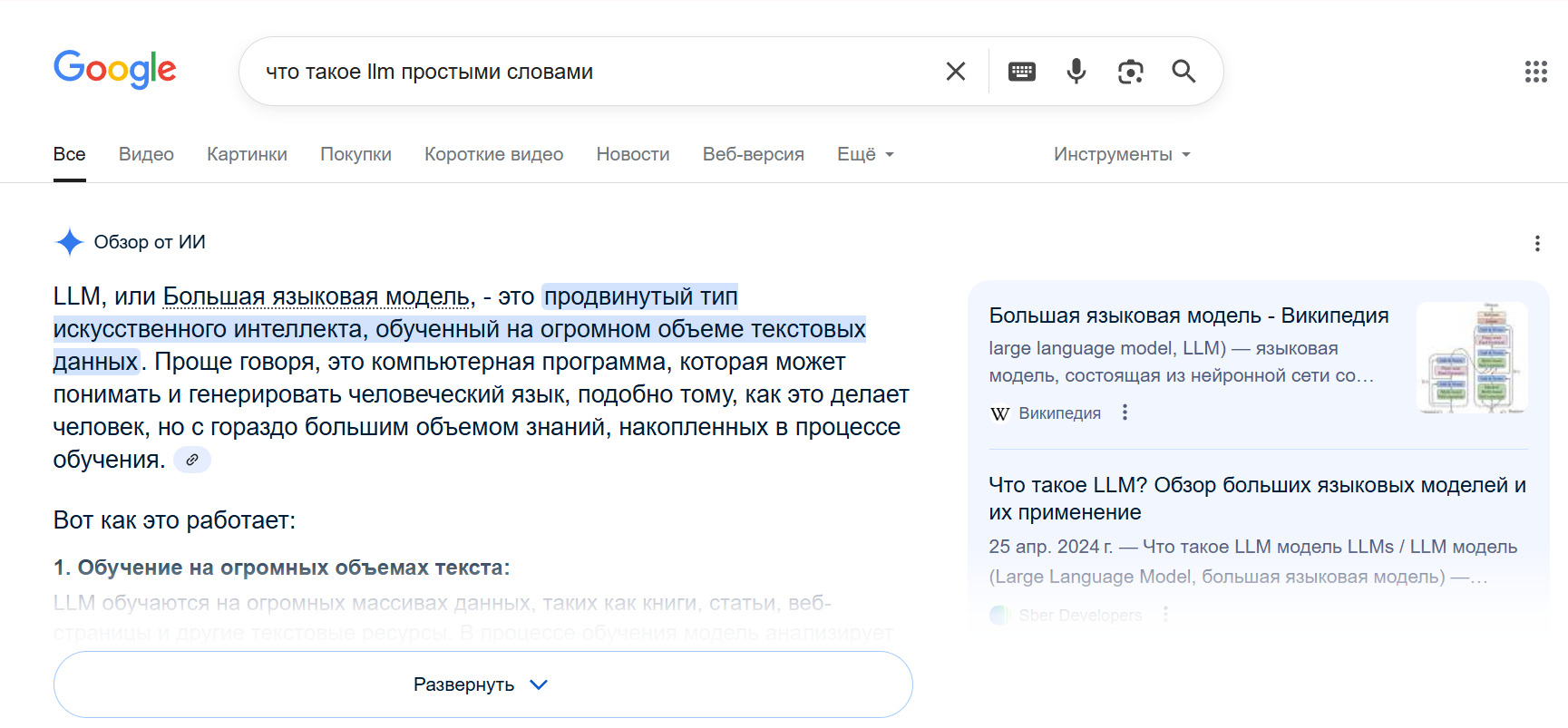

Что такое большая языковая модель? Если коротко: это сложная нейронная сеть, обученная на огромных массивах текста для понимания и генерации человеческого языка. В отличие от простых алгоритмов, работа языковых моделей основана на глубоком обучении и способности распознавать контекст и смысл слов в предложениях.

Современные LLM, такие как GPT-4, Claude или Gemini, содержат миллиарды параметров – настраиваемых «узлов» нейронной сети. Это позволяет им понимать сложные запросы, поддерживать диалог и генерировать связные тексты на самые разные темы.

Как работает языковая модель в упрощенном виде? Она анализирует вводимый текст, сопоставляет его со своей «базой знаний» (данными, на которых обучалась) и генерирует наиболее вероятное продолжение или ответ. При этом модель не просто ищет похожий текст, а «понимает» суть запроса и формирует уникальный ответ.

Важно отметить: большинство языковых моделей не подключены к интернету в реальном времени (хотя некоторые современные системы на их основе, вроде ChatGPT с функцией Browse, имеют такую возможность). Они работают с тем, что узнали в процессе обучения, поэтому их знания ограничены датой последнего обновления.

Как обучаются LLM: данные, архитектура, fine-tuning

Как обучаются большие языковые модели? Процесс состоит из нескольких ключевых этапов:

- Сбор данных. Для обучения современных LLM используются петабайты текстов – книги, статьи, веб-страницы, научные работы, посты в социальных сетях и многое другое. Например, Common Crawl – один из основных источников – содержит более 100 миллиардов веб-страниц.

- Предобработка. Собранные тексты очищаются от ошибок, дубликатов и низкокачественного контента, затем размечаются для обучения.

- Pre-training (предварительное обучение). На этом этапе модель учится предсказывать следующее слово в предложении или заполнять пропуски в тексте. Это самый ресурсоемкий процесс, требующий тысяч GPU и миллионов долларов.

- Fine-tuning (тонкая настройка). После базового обучения модель дополнительно тренируют на специфических задачах – например, на диалогах или написании кода.

- RLHF (Reinforcement Learning from Human Feedback). Современные модели дополнительно обучаются с помощью обратной связи от людей, которые оценивают качество ответов. Это помогает сделать модель более полезной, безопасной и точной.

Архитектура современных LLM основана на трансформерах – особом типе нейронных сетей, представленном Google в 2017 году. Ключевая инновация трансформеров – механизм внимания (attention mechanism), позволяющий модели учитывать взаимосвязи между всеми словами в предложении, а не только ближайшими соседями.

Обучение LLM с нуля – сложный и дорогостоящий процесс, доступный только крупным организациям. Для обучения GPT-4, по оценкам экспертов, потребовалось более 100 миллионов долларов. Поэтому большинство компаний и разработчиков используют уже обученные модели, адаптируя их под свои задачи.

Почему ИИ выбирает определенные источники

Когда мы говорим о том, как использовать большие языковые модели для бизнеса, важно понимать, по каким критериям они отбирают информацию. В отличие от традиционных поисковых систем, LLM не имеют прямых рейтингов сайтов или метрик ссылочной массы. Однако они все равно «предпочитают» определенные источники при формировании ответов.

Основные критерии, по которым языковые модели оценивают достоверность источника:

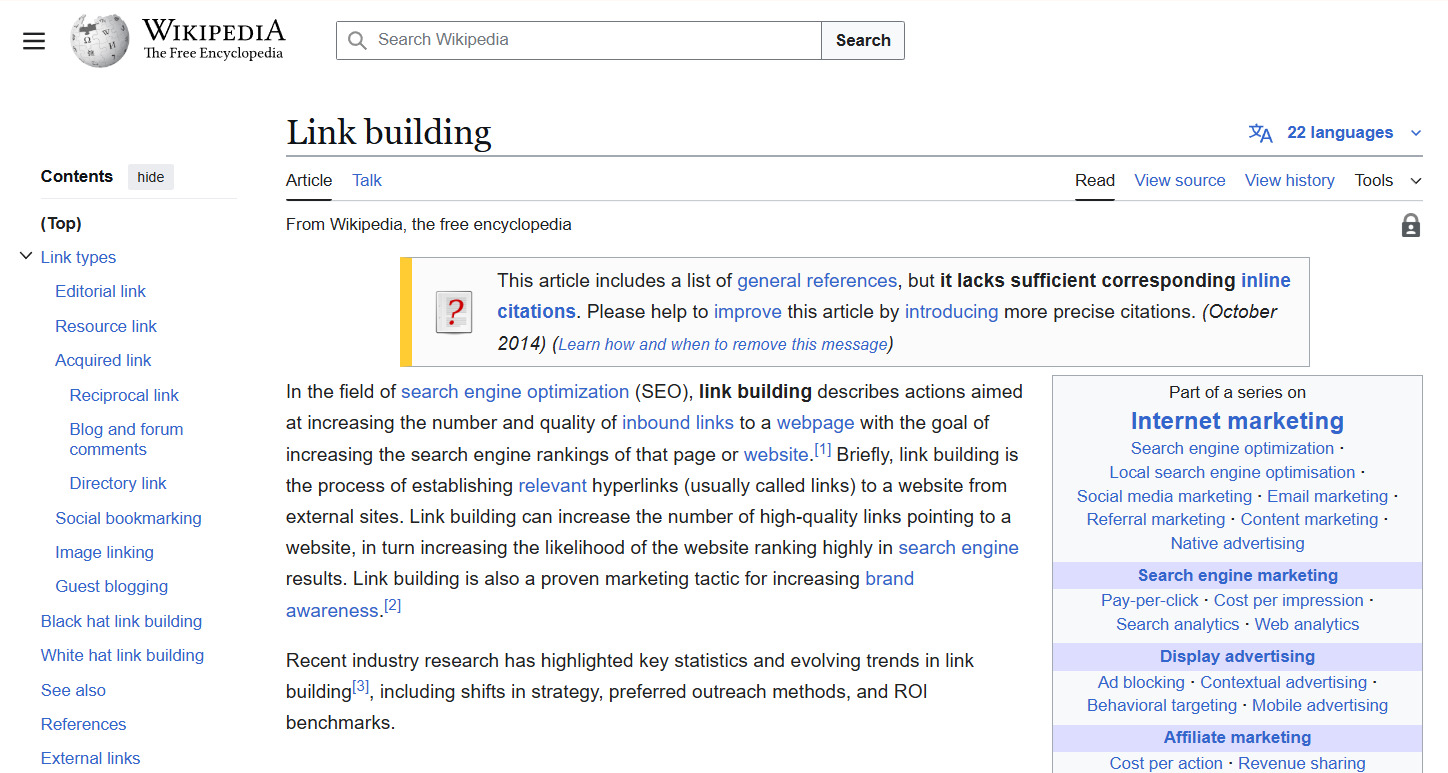

- Авторитетность платформы. Контент с Wikipedia, крупных новостных изданий и научных журналов чаще всего попадает в обучающие данные и считается более надежным.

- Форматирование и структура. Хорошо структурированный контент с четкими заголовками, списками и выделением ключевых моментов лучше обрабатывается при обучении.

- Детальность и полнота. Развернутые объяснения с примерами и контекстом имеют преимущество перед поверхностными материалами.

- Цитируемость. Если на материал часто ссылаются другие источники, это повышает его шансы попасть в ответы LLM.

- Своевременность. Хотя большинство моделей обновляются нечасто, более свежий контент при прочих равных имеет преимущество.

- Уникальность и оригинальность. Модели учатся отличать оригинальный контент от дублированного или рерайта.

- Согласованность с другими источниками. Информация, которая подтверждается несколькими авторитетными источниками, имеет больший вес.

Эти критерии не запрограммированы напрямую, а являются следствием процесса обучения и системы весов, которую нейросеть формирует на основе данных.

Как работает механизм посева контента для LLM

Посев данных для ИИ – это стратегическое размещение контента на платформах, которые с высокой вероятностью будут включены в обучающие наборы данных для языковых моделей.

Что такое посев контента в контексте LLM? Это процесс создания и распространения информации таким образом, чтобы она стала частью «знаний» искусственного интеллекта и появлялась в ответах на релевантные запросы.

Для этого необходимо:

- Определить авторитетные платформы, которые регулярно сканируются для обучения моделей (Wikipedia, GitHub, Stack Overflow, Medium и др.).

- Создать качественный контент, соответствующий форматам и требованиям этих платформ.

- Обеспечить уникальность и ценность информации, чтобы она выделялась среди миллиардов других текстов.

- Получить подтверждение от сообщества в виде лайков, комментариев или других форм взаимодействия.

Посев контента для нейросетей существенно отличается от традиционного SEO. Если для поисковых систем важны ключевые слова, метатеги и бэклинки, то для LLM решающее значение имеет смысловая ценность, структурированность и авторитетность источника.

Технические аспекты интеграции в ответы ИИ

Чтобы понять, как сделать сайт источником для ИИ, важно разобраться в техническом процессе работы языковых моделей с информацией. В отличие от поисковых систем, которые индексируют сайты в реальном времени, LLM работают с предварительно собранными и обработанными данными.

Процесс использования информации в моделях вроде ChatGPT происходит так:

- Сбор данных. Компании-разработчики (OpenAI, Google, Anthropic) собирают огромные массивы текстов из открытых источников – веб-страниц, книг, статей, форумов.

- Токенизация и векторизация. Тексты разбиваются на токены (части слов или целые слова) и преобразуются в числовые векторы – математические представления слов в многомерном пространстве.

- Обучение. Модель обучается предсказывать следующий токен, исходя из предыдущего контекста. В этом процессе она формирует «понимание» связей между концепциями, фактами и идеями.

- Хранение знаний. В отличие от баз данных, LLM не хранят информацию в явном виде. Знания «растворены» в миллиардах параметров нейронной сети.

- Генерация ответов. Когда пользователь задает вопрос, модель не ищет ответ в базе данных, а генерирует его на основе статистических закономерностей, выявленных в процессе обучения.

Более новые версии сервисов на базе LLM могут обращаться к интернету в реальном времени. Это создает дополнительные возможности для того, чтобы ваш контент был найден и использован.

Перед тем, как использовать LLM, их обучают на следующих источниках данных:

- Common Crawl – крупнейший открытый архив интернета, содержащий петабайты данных, собранных с миллиардов веб-страниц. Если ваш сайт проиндексирован поисковыми системами, скорее всего, он уже есть в Common Crawl.

- Wikipedia – один из самых важных источников структурированных знаний для LLM. Контент с Wikipedia считается относительно достоверным и часто используется моделями для фактологических ответов.

- Books Corpus – коллекция из тысяч книг, используемая для обучения пониманию длинных текстов и нарративов.

- WebText/OpenWebText – курированные коллекции веб-контента, часто включающие материалы с высоким рейтингом на платформах типа Reddit.

- GitHub – основной источник данных для моделей, работающих с кодом.

- Stack Exchange/Stack Overflow – важные источники для технических вопросов и ответов.

- Научные публикации – для специализированных моделей и областей, требующих академических знаний.

Если вы хотите, чтобы ваш контент был включен в обучающие данные будущих версий LLM, размещение на этих платформах или включение в эти датасеты значительно повышает ваши шансы. Особенно эффективна стратегия присутствия на нескольких ключевых платформах одновременно – это усиливает «сигнал» о важности вашего контента.

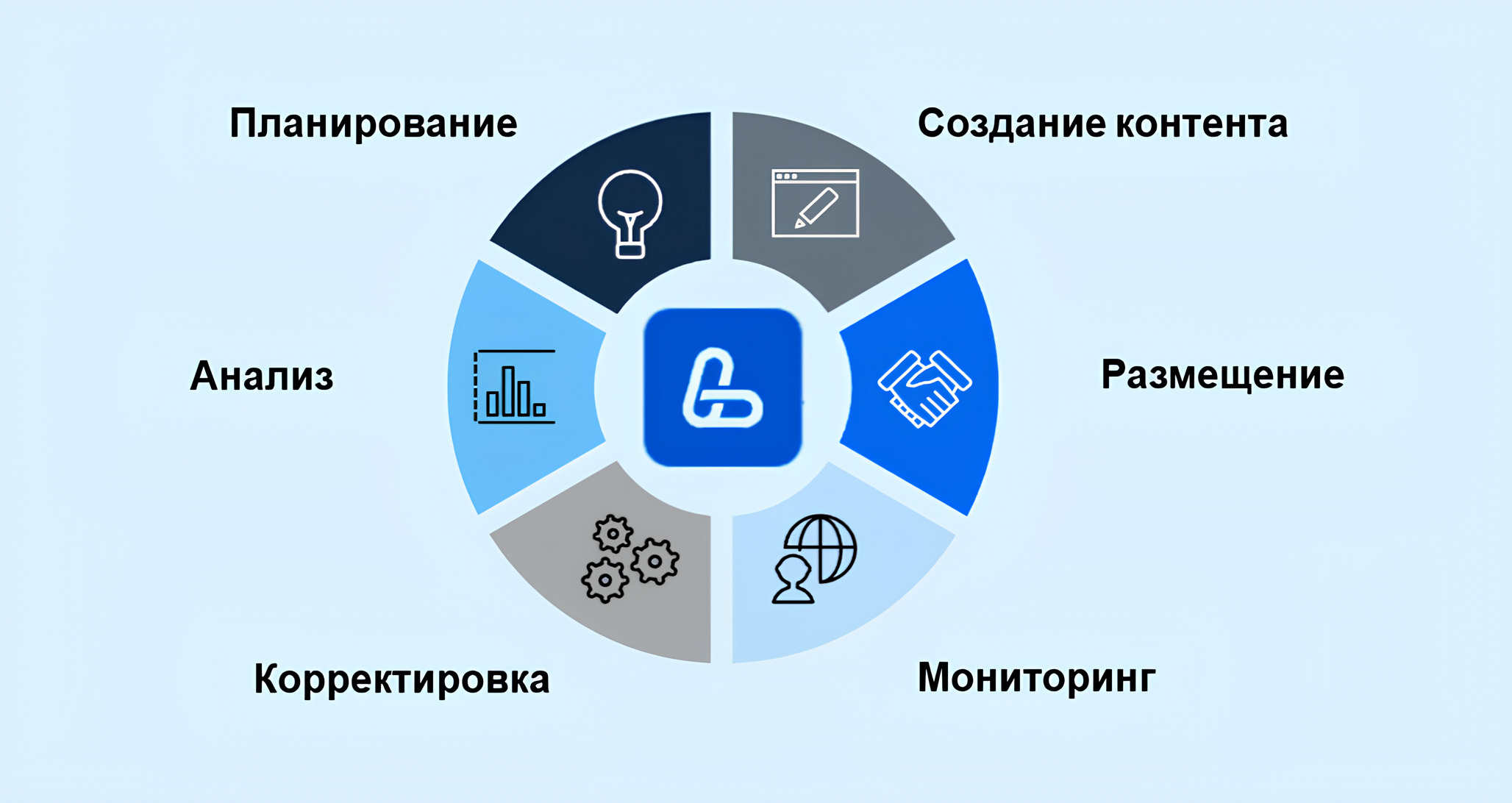

Ключевые этапы посева: от создания до индексации

Подготовка контента (оптимизация под семантику запросов)

В отличие от традиционного SEO, здесь важна не только ключевая фраза, но и семантическое поле – набор связанных понятий и терминов.

Вот пошаговый процесс подготовки контента для языковых моделей:

- Исследование семантического ядра

- Определите основные запросы, на которые должен отвечать ваш контент

- Расширьте их связанными терминами, синонимами и вариациями

- Включите специфические термины вашей отрасли для демонстрации экспертности

- Структурирование информации

- Используйте четкую иерархию заголовков (h1, h2, h3)

- Разбивайте текст на логические блоки с подзаголовками

- Используйте маркированные и нумерованные списки для перечислений

- Создавайте таблицы для сравнения данных

- Оптимизация содержания

- Начинайте с прямого ответа на главный вопрос (важно для featured snippets и ответов LLM)

- Используйте фактическую информацию: цифры, даты, имена, статистику

- Подкрепляйте утверждения ссылками на авторитетные источники

- Добавляйте уникальные примеры и кейсы, которых нет в других источниках

- Проверка на полноту и достоверность

- Убедитесь, что ваш контент отвечает на все аспекты основного вопроса

- Проведите фактчекинг всей информации

- Включите разные точки зрения для сложных тем

Размещение на платформах с высоким приоритетом для LLM

После создания оптимизированного контента следующий этап – его стратегическое размещение. Как начать работу с LLM в контексте посева контента? Ключевой принцип – диверсификация присутствия на авторитетных платформах.

Почему это важно:

- Эффект усиления – когда одна и та же информация появляется на нескольких авторитетных платформах, LLM с большей вероятностью воспримут ее как достоверную.

- Кросс-валидация – модели часто «проверяют» информацию путем сопоставления данных из разных источников.

- Увеличение охвата – разные модели могут использовать разные приоритетные источники данных.

Стратегия размещения должна включать:

- Приоритезацию платформ – начните с наиболее авторитетных ресурсов в вашей отрасли. Для технических тем это могут быть GitHub и Stack Overflow, для научных – arXiv и ResearchGate, для общих тем – Wikipedia и крупные медиа.

- Адаптацию контента – один и тот же материал нужно адаптировать под формат каждой платформы. То, что работает на Medium, может не подойти для Reddit или Wikipedia.

- Последовательное размещение – начните с одной платформы, затем ссылайтесь на этот материал при размещении на других ресурсах, создавая сеть взаимных ссылок.

- Вовлечение сообщества – активно участвуйте в обсуждениях вашего контента, отвечайте на комментарии, дополняйте информацию. Это увеличивает видимость и значимость материала.

Преимущества стратегии посева для бизнеса и экспертов

Увеличение видимости в эпоху ИИ-поиска

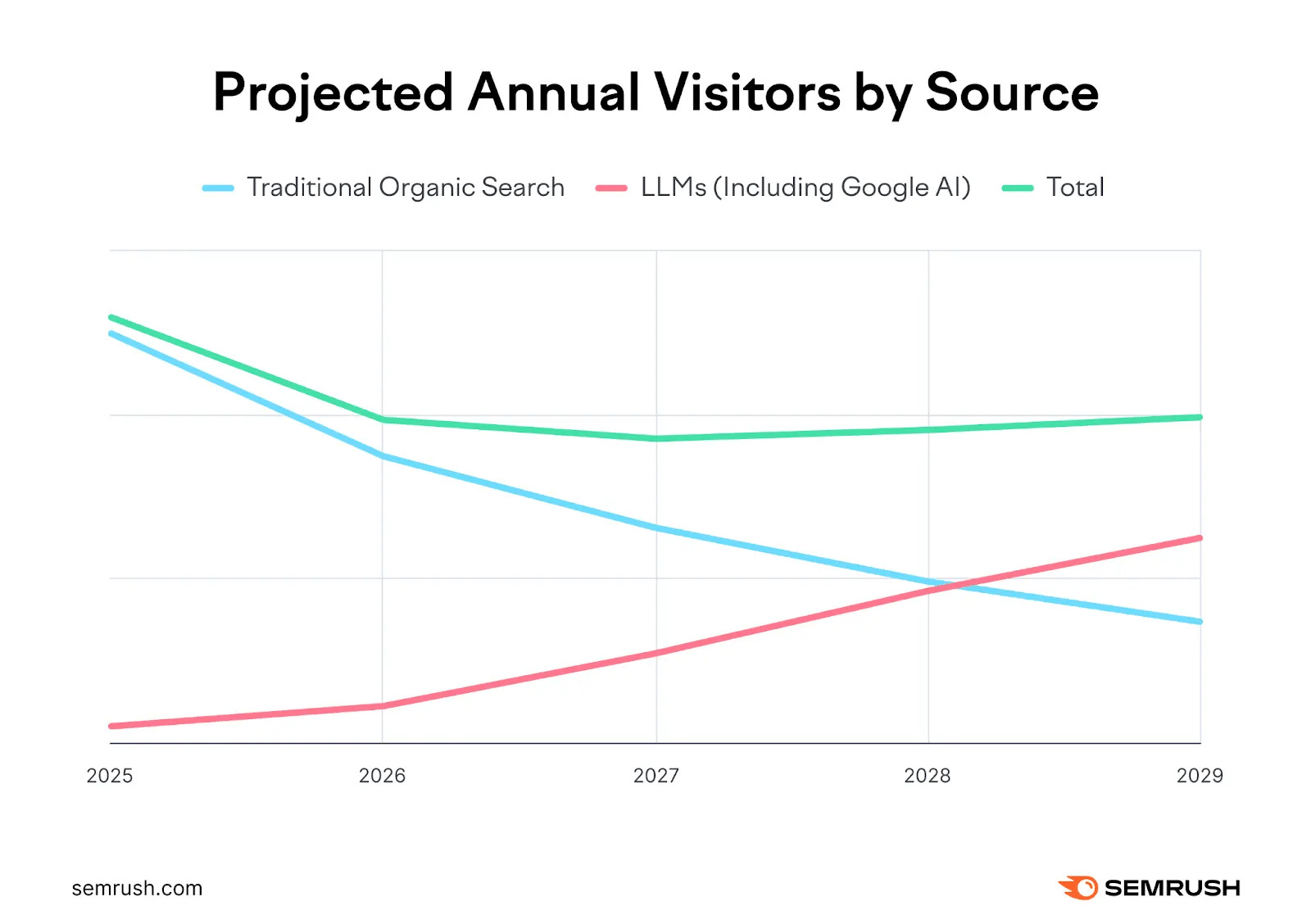

ИИ-поиск постепенно замещает традиционные поисковые системы. Согласно исследованию Gartner, уже к 2026 году трафик из поисковых запросов упадет на 25%. А Semrush предсказывает, что к 2028 году число пользователей ИИ-поиска превысит количество тех, кто пользуется обычными поисковиками.

Вот ключевые преимущества, которые дает стратегия посева контента:

- Новый канал привлечения аудитории. Когда ваш бренд или экспертиза упоминаются в ответах ChatGPT и аналогичных систем, вы получаете доступ к аудитории, которая может даже не искать вас целенаправленно.

- Усиление бренда как авторитета. Если ИИ цитирует вас как эксперта, это автоматически повышает доверие к вашему бренду. Пользователи воспринимают информацию, предоставленную ИИ, как объективную и проверенную.

- Пассивный маркетинг 24/7. После успешного посева ваш контент работает на вас постоянно, отвечая на вопросы пользователей даже когда вы спите. Это масштабирует вашу экспертизу без дополнительных затрат.

- Охват ранней стадии воронки продаж. Пользователи часто обращаются к ИИ на этапе исследования проблемы, когда еще не сформировали запрос на конкретное решение. Присутствие в ответах на этом этапе помогает формировать потребность в вашем продукте.

- Обход блокировки рекламы. В отличие от традиционной рекламы, упоминания в ответах ИИ не блокируются адблокерами и воспринимаются как органический контент.

Как посев контента заменяет традиционное SEO

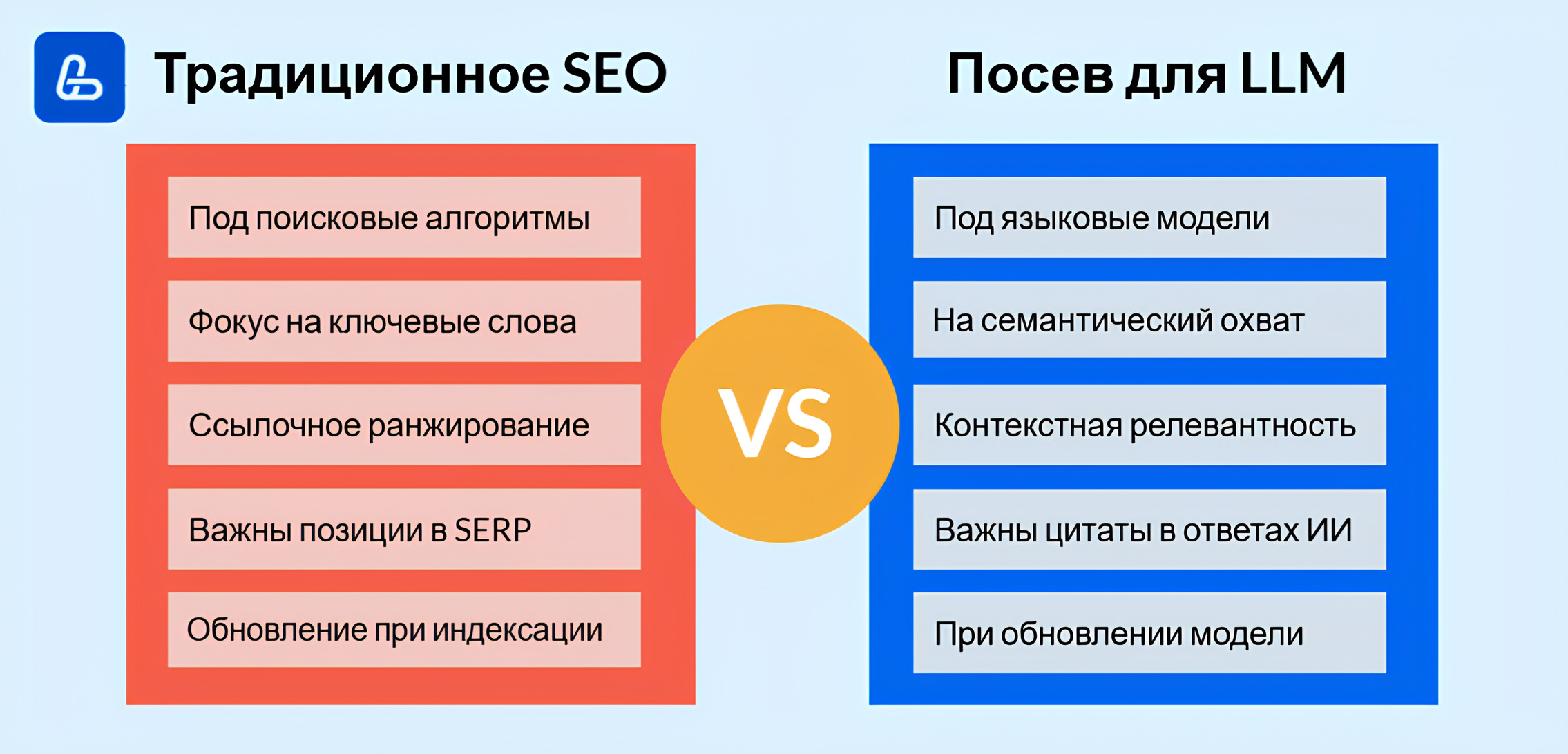

LLM-посев отличается от привычного SEO по следующим критериям:

Изучение LLM и стратегий работы с ними приводит к важному выводу: мы переживаем фундаментальные изменения в способах поиска и потребления информации. Эти изменения заставляют пересмотреть традиционные методы SEO.

Подробное сравнение традиционного SEO и стратегии посева для LLM:

| Аспект | Традиционное SEO | Посев для LLM |

|---|---|---|

| Целевая система | Поисковые алгоритмы | Языковые модели |

| Ключевые метрики | Позиции в SERP, кликабельность | Частота цитирования в ответах ИИ |

| Оптимизация контента | Под ключевые слова и поисковые намерения | Под семантические связи и когнитивные фреймы |

| Авторитетность | Определяется ссылочной массой и доменными метриками | Определяется качеством контента и репутацией платформы |

| Обновление результатов | При индексации (дни/недели) | При обновлении модели (месяцы/годы, редко – моментально) |

| Формат представления | 10 синих ссылок + рекламные блоки | Прямой ответ, часто без ссылок |

| Взаимодействие с пользователем | Переход на сайт необходим | Информация потребляется прямо в интерфейсе ИИ |

Почему посев контента становится новым SEO:

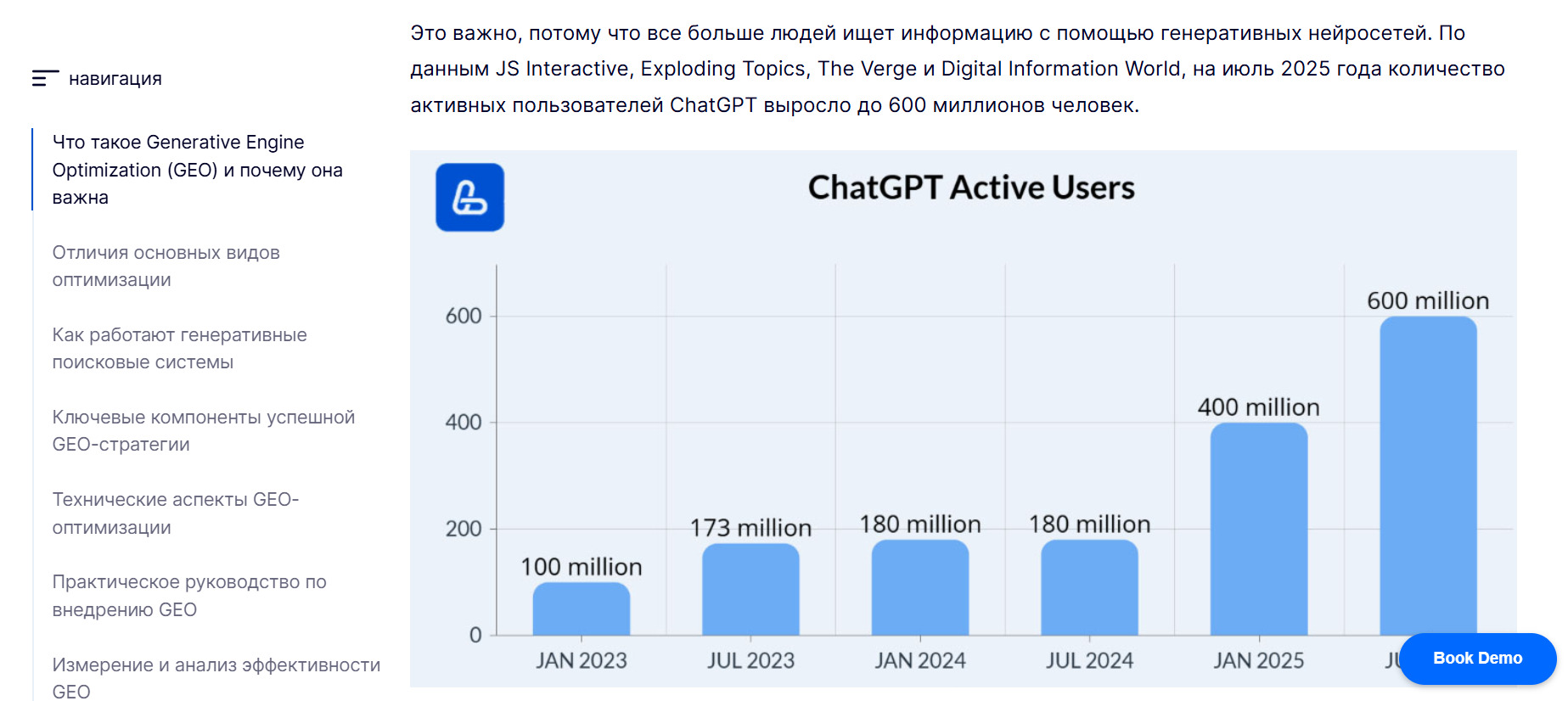

- Изменение пользовательского поведения. Все больше людей предпочитают получать готовые ответы от ИИ, а не просматривать множество сайтов. По данным исследования Menlo Ventures, на июнь 2025 года 61% взрослых в США за последние полгода пользовались инструментами на основе ИИ, и почти 20% прибегают к ним ежедневно. В мировом масштабе это 1,7-1,8 миллиарда пользователей, из которых 500-600 миллионов активны каждый день.

- Снижение CTR в традиционном поиске. С появлением zero-click результатов (когда ответ показывается прямо в поисковой выдаче) и ростом использования ИИ, количество переходов на сайты из поисковой выдачи сокращается.

- Длительный эффект. Если ваш контент попал в обучающие данные LLM, он продолжает влиять на ответы до следующего обновления модели, что может быть значительно дольше, чем сохранение позиций в поисковой выдаче.

- Контекстуальное присутствие. В отличие от поисковых систем, где вы можете показаться только по релевантному запросу, в ответах ИИ ваш бренд может упоминаться в широком спектре контекстов.

Однако полностью отказываться от традиционного SEO пока рано. Оптимальная стратегия – интеграция обоих подходов:

- Используйте традиционное SEO для привлечения трафика здесь и сейчас

- Развивайте стратегию посева контента для долгосрочного присутствия в эпоху доминирования ИИ

- Адаптируйте существующий SEO-контент под требования языковых моделей

- Отслеживайте изменения в том, как пользователи вашей ниши ищут информацию

Лучшие площадки для размещения контента

Официальные и авторитетные веб-сайты

LLM отдают предпочтение контенту с платформ, которые имеют строгий редакционный контроль и высокую репутацию. Это связано с тем, что в процессе обучения модели «усваивают» иерархию достоверности источников, наблюдаемую в обучающих данных.

Размещение на официальных сайтах дает несколько преимуществ:

- Больший вес информации при формировании ответов

- Повышенные шансы сохранения в базе знаний при обновлении модели

- Лучшее сохранение авторства и атрибуции

- Более точная передача специфических деталей

Примеры:

Wikipedia – бесспорно, главный источник структурированных знаний для LLM. Модели часто опираются на Wikipedia для базовых определений и фактической информации.

Как использовать: создавайте и редактируйте статьи по темам вашей экспертизы, следуя строгим правилам нейтральности и подтверждения информации. Прямая реклама запрещена, но корректное упоминание вашей компании как части индустрии или пионера технологии допустимо.

Правительственные и образовательные ресурсы (.gov, .edu, научные журналы) считаются высоконадежными источниками, особенно для статистических данных и официальной информации.

Как использовать: публикуйте исследования в сотрудничестве с университетами, участвуйте в государственных отчетах и образовательных инициативах, предоставляйте экспертные комментарии для официальных докладов.

Крупные медиа (BBC, The New York Times, Reuters) часто используются LLM для получения актуальной информации о событиях и трендах.

Как использовать: работайте с журналистами через HARO или прямые контакты, предлагайте экспертные комментарии, создавайте информационные поводы, достойные освещения в крупных СМИ.

Отраслевые авторитетные сайты. Для каждой отрасли существуют свои признанные лидеры мнений. Например, для технологий это могут быть TechCrunch или Wired, для маркетинга – HubSpot или MarketingProfs.

Как использовать: предлагайте гостевые статьи, делитесь уникальными исследованиями или данными, становитесь постоянным экспертом-комментатором.

Стратегия работы с авторитетными сайтами требует долгосрочного подхода и высоких стандартов контента. Однако это наиболее надежный способ обеспечить присутствие вашей экспертизы в ответах LLM на годы вперед.

Платформы вопросов и ответов (Q&A)

Преимущество Q&A-платформ в том, что они позволяют точно таргетировать конкретные вопросы, на которые ваши потенциальные клиенты ищут ответы. Когда пользователь задает похожий вопрос языковой модели, ваша экспертиза с большей вероятностью будет включена в ответ.

Эффективная стратегия работы с Q&A-платформами включает:

- Поиск релевантных вопросов по вашей экспертизе, особенно тех, которые имеют высокий просмотр, но недостаточно качественные ответы.

- Создание исчерпывающих ответов с конкретными примерами, данными и, где уместно, ссылками на ваши ресурсы.

- Регулярное участие в сообществе – не ограничивайтесь одноразовыми ответами, становитесь активным участником.

- Установление авторитета через последовательный набор рейтинга и положительных отзывов.

- Обновление старых ответов для поддержания их актуальности и релевантности.

Примеры:

Quora – международная платформа с миллионами пользователей, где можно отвечать на вопросы практически по любой теме. Ответы экспертов с Quora часто попадают в датасеты для обучения LLM.

Как использовать: размещайте ответы самостоятельно или обратитесь в LinkBuilder.com для стратегического размещения ответов в Quora. Наши специалисты подберут релевантные обсуждения на Quora, напишут экспертные ответы и разместят их с надежных аккаунтов.

Stack Overflow и другие сайты сети Stack Exchange – незаменимый ресурс для технических тем. Их контент активно используется при обучении моделей работе с программированием и IT-темами.

Как использовать: на Stack Overflow критически важно соблюдать форматирование кода и технических деталей – это влияет на то, как LLM будут воспроизводить вашу информацию.

Reddit – хотя формально не является Q&A-платформой, многие сабреддиты работают в подобном формате через посты с вопросами и комментарии с ответами.

Как использовать: активно участвуйте в обсуждениях на платформе или обратитесь в LinkBuilder.com для размещения ссылок на Reddit. Наши эксперты помогут найти релевантные обсуждения на Reddit и опубликовать в них ваши ссылки, что особенно полезно учитывая огромный объем контента на платформе.

Бесплатные большие языковые модели часто обучаются именно на таких открытых источниках данных, поэтому качественные ответы на популярных Q&A-платформах имеют высокие шансы попасть в обучающие датасеты.

Агрегаторы контента и экспертные платформы

Эти ресурсы особенно ценны, поскольку собирают и структурируют высококачественный контент, который с высокой вероятностью попадает в обучающие датасеты.

Для максимальной эффективности публикуйте на этих платформах:

- Исследования и аналитику с уникальными данными, которых нет в других источниках

- Детальные руководства и обучающие материалы с пошаговыми инструкциями

- Кейс-стади с конкретными результатами и методологией, которую можно воспроизвести

- Экспертные мнения по актуальным трендам вашей отрасли

Важно: подкрепляйте утверждения данными и ссылками на источники – это повышает достоверность информации в глазах как читателей, так и алгоритмов, отбирающих контент для обучения LLM.

Примеры:

HARO (Help a Reporter Out) – сервис, соединяющий журналистов с экспертами. Цитаты экспертов из HARO часто используются в СМИ, а затем попадают в обучающие данные языковых моделей.

Как использовать: сами отправляйте экспертные ответы на платформу или закажите HARO в LinkBuilder.com. Наша команда помогает автоматизировать мониторинг релевантных запросов в HARO и оперативно предоставлять экспертные комментарии, существенно повышая шансы на публикацию.

Medium – популярная платформа для публикации статей с системой кураторства, которая продвигает качественный контент. Статьи с высокой вовлеченностью имеют хорошие шансы попасть в обучающие выборки.

Как использовать: размещайтесь не только на своем профиле, но и в крупных публикациях на Medium (например, The Startup, Better Programming, Towards Data Science), что значительно увеличивает охват.

GitHub – незаменимый ресурс для технической документации и open-source проектов. Многие LLM специально обучаются на репозиториях GitHub для улучшения способности работать с кодом.

Как использовать: создавайте детальные ReadME, вики-страницы и документацию к проектам – этот контент высоко ценится при обучении технических аспектов языковых моделей.

ResearchGate – платформа для публикации научных работ, которая часто используется при обучении LLM для научных и академических тем.

Как использовать: размещайте свои научные работы на площадке. Даже препринты и рабочие материалы на этих платформах могут попасть в обучающие данные, если содержат ценную информацию.

HackerNoon/Dev.to – специализированные платформы для технического контента, популярные среди разработчиков. Поддерживают open-source культуру, поэтому можно публиковать туториалы, кейсы и даже личные размышления о разработке.

Как использовать: зарегистрируйтесь через GitHub, Twitter или email, затем создавайте посты в Markdown, добавляя теги для удобного поиска. Взаимодействуйте с комьюнити – комментируйте, ставьте реакции и сохраняйте понравившиеся материалы.

Социальные сети и форумы

Социальные сети и форумы – важные источники для обучения LLM, особенно в темах, связанных с актуальными трендами и общественным мнением.

Twitter (X) – треды авторитетных пользователей имеют большое значение, особенно для технических и бизнес-тем. Многие разработчики LLM специально включают контент с Twitter в обучающие данные для отслеживания современного словоупотребления и трендов.

Как использовать: создавайте развернутые треды по вашей экспертной теме, используйте хэштеги для повышения видимости, взаимодействуйте с другими экспертами для усиления охвата.

LinkedIn – платформа для B2B-ниш и профессионального контента. Посты экспертов с высокой вовлеченностью часто включаются в обучающие датасеты.

Как использовать: делитесь инсайтами из индустрии, данными исследований, аналитикой трендов – такой контент имеет высокую ценность при обучении LLM бизнес-тематике.

Специализированные форумы (например, Indie Hackers для стартапов, Hacker News для технологий, Product Hunt для новых продуктов) часто становятся источниками нишевой экспертизы для LLM.

Как использовать: добавляйте свои продукты, публикуйте обновления и взаимодействуйте с аудиторией. Платформа идеально подходит для поиска инновационных решений, нетворкинга и продвижения собственных проектов.

Ключевой фактор для всех социальных платформ – уровень вовлеченности. LLM чаще выбирают контент с высоким показателем вовлеченности (лайки, комментарии, репосты), так как это служит социальным доказательством ценности информации.

Для максимальной эффективности:

- Стимулируйте обсуждение – задавайте открытые вопросы, просите поделиться опытом.

- Отвечайте на комментарии – это увеличивает вовлеченность.

- Используйте визуальные элементы – они привлекают больше внимания.

- Публикуйте в оптимальное время – когда ваша аудитория наиболее активна.

- Участвуйте в трендовых дискуссиях с добавлением вашей экспертизы.

Новостные и аналитические ресурсы

Новостные и аналитические ресурсы играют особую роль в обучении языковых моделей. Они формируют представление LLM о текущих событиях, трендах и фактах.

Примеры:

Bloomberg, Forbes – основные источники для финансовых данных и бизнес-аналитики. Языковые модели часто опираются на эти ресурсы при ответах на вопросы об экономике, инвестициях и состоянии рынков.

Как использовать: предлагайте экспертные комментарии для статей, публикуйте гостевые колонки (если у вас есть подтвержденная экспертиза), участвуйте в исследованиях и опросах этих изданий.

TechCrunch, Wired – авторитетные источники по технологиям и стартапам. Упоминание в этих изданиях повышает шансы, что ваша компания или продукт будут включены в ответы LLM на вопросы о инновациях в вашей отрасли.

Как использовать: создавайте информационные поводы через запуск интересных продуктов, проведение исследований или публикацию уникальных данных, которые привлекут внимание технических журналистов.

VentureBeat, The Verge – важные ресурсы для тем на стыке технологий, бизнеса и культуры. Это авторитетные медиа, где можно предложить свою статью через раздел «Submit a Story» или связавшись с редакцией по email.

Как использовать: подготовьте уникальный, хорошо проработанный контент с экспертным мнением или эксклюзивными данными. После публикации активно участвуйте в обсуждениях и продвигайте материал в соцсетях для максимального охвата.

Специализированные отраслевые медиа – для каждой ниши существуют свои авторитетные издания, которые становятся источниками при обучении LLM специфическим темам. Например, для маркетинга это MarketingLand и Search Engine Journal, для медицины – MedicalNewsToday и The Lancet. Найдите издания для своих тематик и активно сотрудничайте с ними.

Важные аспекты работы с новостными ресурсами:

- Оперативность – предлагайте комментарии и инсайты по горячим темам вашей отрасли, пока они актуальны.

- Данные и исследования – журналисты ценят эксклюзивные данные и готовы давать за них упоминания.

- Регулярность – стройте долгосрочные отношения с ключевыми изданиями вашей ниши.

- Мультимедийность – предлагайте не только текст, но и инфографику, видео, интерактивные элементы.

Присутствие в авторитетных новостных и аналитических изданиях особенно важно для тем, которые быстро развиваются или связаны с актуальными событиями. При обновлении языковых моделей разработчики часто дополняют обучающие данные свежим контентом из проверенных медиа, чтобы модели оставались в курсе последних трендов.

Оптимизация контента для языковых моделей

Структура и стиль для максимального охвата

Как использовать большие языковые модели в своих маркетинговых стратегиях? Начните с правильной структуры контента. LLM лучше понимают и «запоминают» информацию, которая имеет четкую организацию и логику.

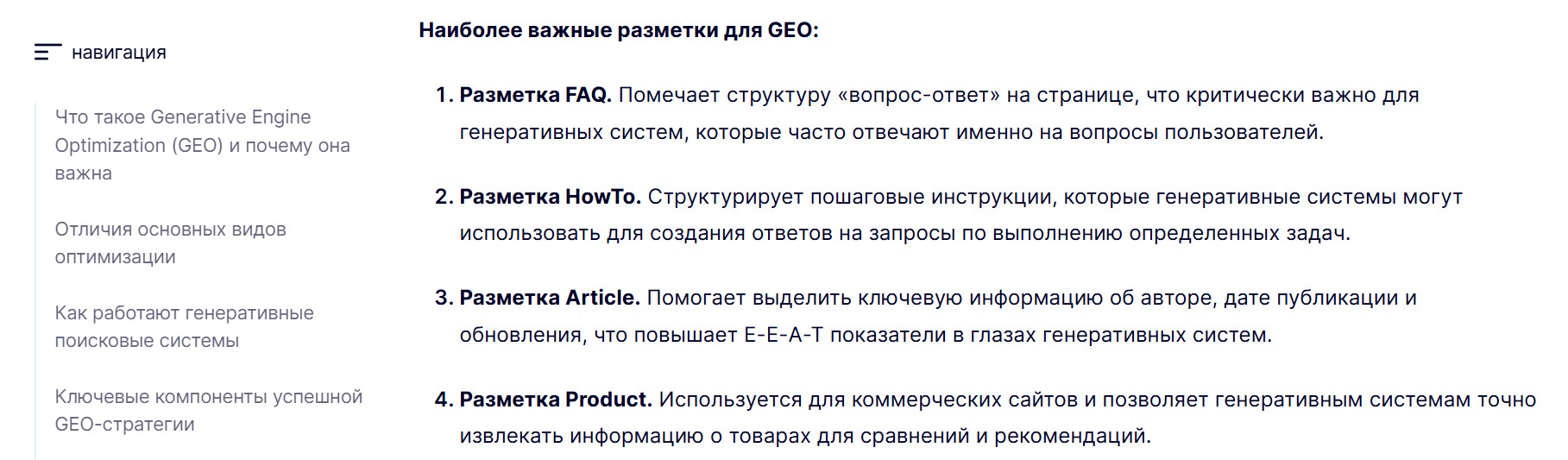

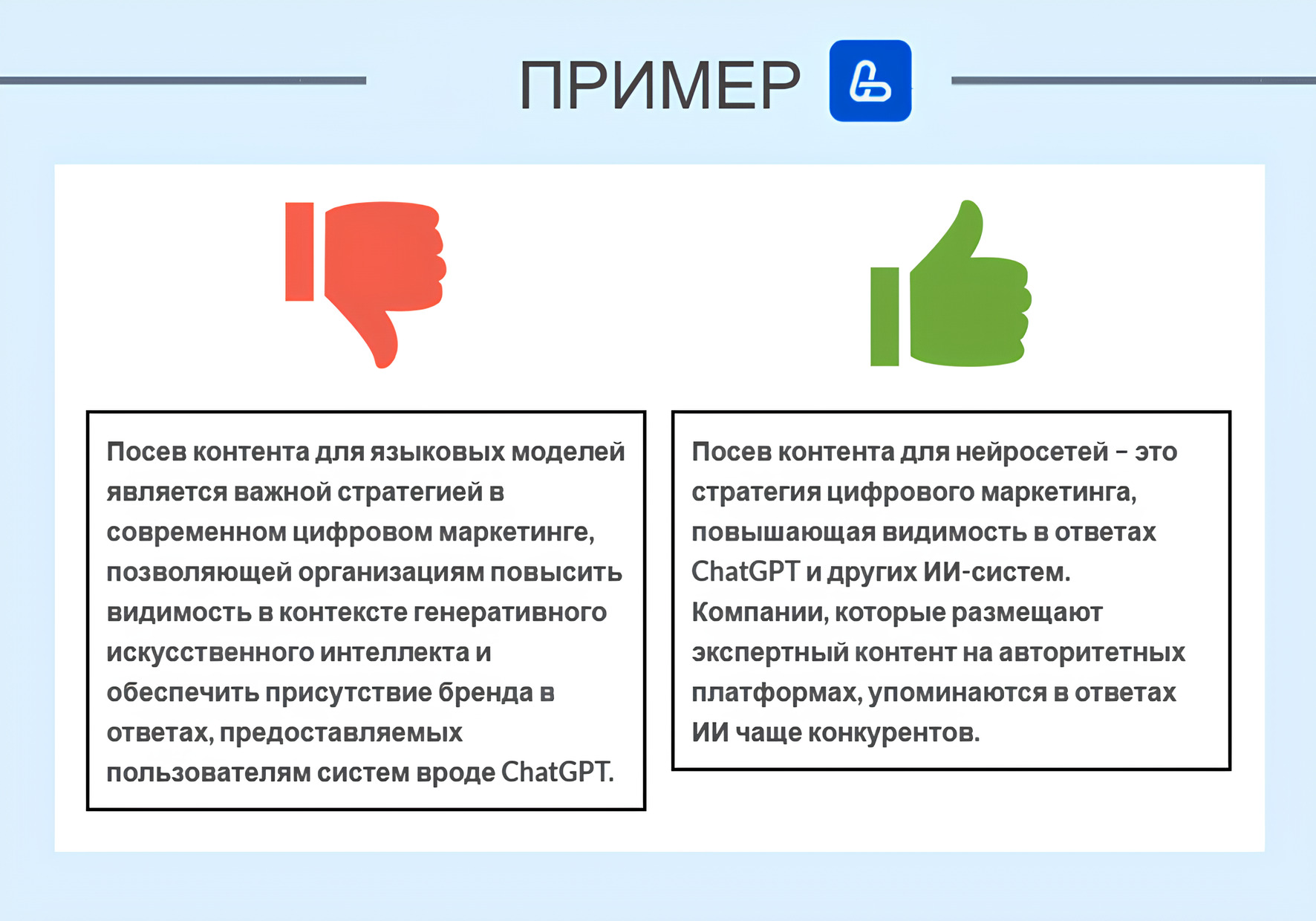

Расскажем про ключевые элементы структуры, которые нравятся языковым моделям, и покажем их на примере нашей статьи «Generative Engine Optimization (GEO): как продвигать сайты в эпоху ИИ».

Четкая иерархия заголовков (H1-H4). Она помогает ИИ понять важность и взаимосвязь разделов. Каждый заголовок должен точно отражать содержание следующего за ним текста. Избегайте креативных, но неинформативных заголовков – модели предпочитают конкретику.

Маркированные и нумерованные списки. Они структурируют информацию и делают ее более «усваиваемой» как для людей, так и для ИИ.

Используйте списки для:

- Перечисления шагов в процессе

- Описания характеристик

- Представления вариантов решения проблемы

FAQ-блоки. Идеально соответствуют формату «запрос-ответ», в котором работают LLM. Включайте в контент часто задаваемые вопросы с развернутыми ответами.

Таблицы. Отлично структурируют сравнительную информацию. Языковые модели становятся все лучше в понимании табличных данных и могут точнее цитировать такую информацию.

Параграфы среднего размера. Параграфы в 3-5 предложений с четкой основной мыслью воспринимаются LLM лучше, чем длинные полотна текста или очень короткие отрывки без контекста.

Что касается стиля, для максимального охвата в LLM рекомендуется:

- Использовать терминологию вашей ниши, но с пояснениями для непрофессионалов. Это помогает моделям идентифицировать вас как эксперта, сохраняя доступность контента.

- Включать синонимы и связанные термины. Например, если пишете о «посеве контента», упомяните также «размещение контента», «распространение информации», «включение в обучающие данные». Это расширяет семантическое поле и увеличивает шансы появления в ответах на разные формулировки запросов.

- Использовать естественный язык без переспама ключевыми словами. Языковые модели уже умеют распознавать неестественные тексты, созданные только для SEO.

- Поддерживать логические связки между предложениями и параграфами. LLM лучше понимают и воспроизводят контент, где есть четкая логическая последовательность.

- Делать акцент на фактической информации – цифры, даты, названия, имена. Такой контент чаще воспринимается как авторитетный.

Визуальные элементы и их роль

Визуальные элементы играют все более важную роль в оптимизации контента для ИИ. Современные мультимодальные LLM (GPT-4V, Gemini, Claude 3) умеют «видеть» и интерпретировать изображения.

Графики и диаграммы позволяют наглядно представить статистику и тренды. Для LLM особенно важно, чтобы они содержали:

- Четкие подписи осей

- Легенду, объясняющую все элементы

- Заголовок, отражающий суть данных

Схемы и инфографика помогают структурировать сложные процессы. Они особенно полезны для объяснения как работают большие языковые модели или других технических концепций.

Скриншоты интерфейсов с пошаговыми инструкциями отлично работают для обучающих материалов. Например, показывая как начать работу с LLM, включайте скриншоты реального интерфейса с аннотациями.

Хотя традиционные LLM работают в основном с текстом, подписи к изображениям играют критическую роль:

- Альтернативный текст (alt-text) – это текстовое описание изображения, которое индексируется поисковыми системами и используется в обучающих данных для LLM. Хороший alt-text кратко и точно описывает содержимое изображения.

- Подписи под изображениями должны не просто дублировать очевидное («На фото графика»), а дополнять контекст: «График показывает рост использования ИИ в маркетинге за 2022-2023 годы».

- Контекстное окружение – текст до и после изображения должен логически связываться с визуальным элементом, чтобы LLM могла установить эту связь в процессе обучения.

Как изображения улучшают понимание контекста для ИИ:

- Визуальное подтверждение фактов – когда текстовая информация подкрепляется визуальными данными, модели с большей вероятностью воспринимают ее как достоверную.

- Расширение семантического поля – изображения с подписями добавляют дополнительные термины и связи в семантическую сеть вашего контента.

- Дополнительные структурные маркеры – визуальные элементы создают дополнительные «точки привязки» в тексте, которые помогают LLM ориентироваться в структуре документа.

Практические рекомендации для визуальных элементов:

- Используйте оригинальные изображения вместо стоковых – они увеличивают уникальность контента

- Добавляйте брендинг на диаграммы и инфографику – это увеличит шансы атрибуции при цитировании

- Обеспечивайте читаемость текста на изображениях – это важно для сканирования и распознавания

- Сопровождайте сложные данные визуализацией – это увеличивает шансы корректной интерпретации LLM

Как работает языковая модель с визуальным контентом? При обучении мультимодальных моделей визуальные элементы обрабатываются через системы компьютерного зрения, которые затем связывают полученную информацию с текстовым контекстом. Это позволяет моделям «понимать» изображения и отвечать на вопросы о них.

Даже если ваш контент будет использоваться преимущественно текстовыми LLM, качественные визуальные элементы с хорошими подписями повышают общее качество материала и шансы на его включение в обучающие данные.

Проблемы и ограничения работы с LLM

Типичные сложности при посеве

Пользователи сталкиваются с рядом практических сложностей, которые важно учитывать при планировании стратегии:

Конкуренция за ограниченные слоты в датасетах становится все более острой. Разработчики LLM не могут включить весь интернет в обучающие данные из-за:

- Вычислительных ограничений (даже самые мощные системы имеют пределы)

- Стоимости обучения (каждый гигабайт данных увеличивает затраты)

- Необходимости фильтрации низкокачественного контента

Это создает своеобразную «борьбу за внимание» между создателями контента. По мере того как все больше компаний осознают важность посева контента для нейросетей, конкуренция будет только усиливаться.

Риски устаревания информации – серьезная проблема для LLM. Большинство моделей обновляются не непрерывно, а периодически, что создает «слепые пятна» в их знаниях. Это приводит к двум противоречивым требованиям:

- Создавать вечнозеленый контент, который будет актуален долгое время

- Регулярно обновлять материалы, чтобы они включались в новые версии моделей

Отсутствие прозрачности в процессе отбора контента для обучения. В отличие от традиционных поисковых систем, которые публикуют рекомендации для вебмастеров, разработчики LLM редко раскрывают точные критерии включения материалов в обучающие данные.

Потеря атрибуции – частая проблема при посеве контента для ИИ. Когда LLM цитирует информацию, она редко указывает первоисточник, что снижает ценность посева для бренда.

Стратегии преодоления этой проблемы включают:

- Постоянное упоминание бренда в контексте ключевой информации

- Создание уникальных терминов или фреймворков, ассоциирующихся с брендом

- Размещение на множестве авторитетных платформ для усиления связи информации с брендом

Языковые и культурные барьеры также создают сложности. Большинство LLM обучаются преимущественно на англоязычном контенте, что ставит в невыгодное положение материалы на других языках. Бесплатные большие языковые модели часто демонстрируют худшее понимание неанглийских текстов.

Технические ограничения платформ могут затруднять посев. Многие важные платформы имеют строгие правила публикации:

- Wikipedia требует нейтральной точки зрения и проверяемости

- GitHub предназначен для кода и технической документации, а не маркетинга

- Научные журналы принимают только рецензируемые исследования

Сложность измерения эффективности – еще одна проблема. В отличие от SEO, где есть четкие метрики (позиции, трафик, конверсии), успех посева контента для LLM сложно измерить напрямую. Вы можете тестировать запросы к моделям, но полную картину видимости получить сложно.

Наконец, постоянно меняющиеся алгоритмы обучения LLM означают, что стратегии, работающие сегодня, могут потерять эффективность завтра. Разработчики постоянно совершенствуют свои подходы к фильтрации и отбору обучающих данных.

Несмотря на эти сложности, компании, которые раньше начнут системную работу с посевом контента для LLM, получат значительное преимущество в новой парадигме информационного поиска и потребления.

Этические вопросы

Изучение LLM невозможно без понимания этических аспектов посева контента. Эта область находится на пересечении технологий, маркетинга и общественной ответственности.

Дезинформация – одна из центральных этических проблем. Языковые модели могут непреднамеренно распространять ложную информацию, если она присутствует в их обучающих данных.

Для этичного посева контента:

- Проверяйте фактическую точность всей информации

- Указывайте источники утверждений, особенно для спорных тем

- Избегайте преувеличений и необоснованных обобщений

- Обновляйте контент при появлении новых данных

Манипуляция ответами ИИ тоже вызывает серьезные опасения. Некоторые компании пытаются «взломать» LLM, чтобы продвигать свои продукты или подавлять негативную информацию. Это подрывает доверие пользователей и может привести к ужесточению фильтров со стороны разработчиков LLM.

Проблема предвзятости и разнообразия также заслуживает внимания. При посеве контента важно учитывать:

- Инклюзивность терминологии и примеров

- Представление различных точек зрения

- Избегание стереотипов и обобщений

Защита интеллектуальной собственности становится сложнее в эпоху LLM. То, как работают языковые модели, часто включает обработку и переформулирование существующего контента, что поднимает вопросы авторского права и атрибуции.

Прозрачность намерений – еще один важный аспект того, как посеять контент для ИИ этично. Будьте открыты относительно своих целей:

- Избегайте создания поддельных профилей для распространения контента

- Не маскируйте рекламные материалы под независимые исследования

- Раскрывайте коммерческие интересы и аффилиации

Этические рекомендации для посева контента:

- Создавайте ценность – фокусируйтесь на предоставлении реальной пользы для аудитории, а не только на продвижении

- Придерживайтесь правил платформ – соблюдайте условия использования сайтов, на которых размещаете контент

- Будьте прозрачны – четко идентифицируйте себя и свои интересы при публикации

- Уважайте приватность – не включайте в посев личные данные без согласия

- Стремитесь к долгосрочному влиянию – вместо краткосрочных трюков, которые могут подорвать доверие

Важно помнить: разработчики LLM постоянно совершенствуют фильтры против манипуляций. Этичный подход не только более правильный с моральной точки зрения, но и более устойчивый в долгосрочной перспективе.

Пошаговое руководство: как сделать сайт источником для ИИ

Шаг 1: Анализ текущего контента на соответствие критериям LLM

Первый шаг на пути к тому, как сделать сайт источником для ИИ – это аудит существующего контента. Вам нужно оценить, насколько ваши материалы соответствуют предпочтениям языковых моделей.

Начните с анализа по следующим параметрам:

- Фактическая насыщенность – подсчитайте количество фактов, цифр, дат и конкретных примеров на страницу. LLM предпочитают информационно насыщенный контент с проверяемыми утверждениями.

- Структурная четкость – проверьте наличие:

- Логической иерархии заголовков (H1-H4)

- Списков и перечислений там, где это уместно

- Таблиц для сравнительных данных

- Подзаголовков, разбивающих текст на смысловые блоки

- Полнота раскрытия темы – оцените, насколько исчерпывающе ваш контент отвечает на ключевые вопросы аудитории.

- Уникальность и оригинальность – проверьте, содержит ли ваш контент информацию, которую сложно найти в других источниках: оригинальные исследования, уникальные кейсы, экспертные инсайты.

- Актуальность информации – отметьте материалы, содержащие устаревшие данные или рекомендации, которые нуждаются в обновлении.

- Стилистическая ясность – оцените читаемость и доступность текста. Избегайте излишне сложных конструкций, жаргона без пояснений и очень длинных предложений.

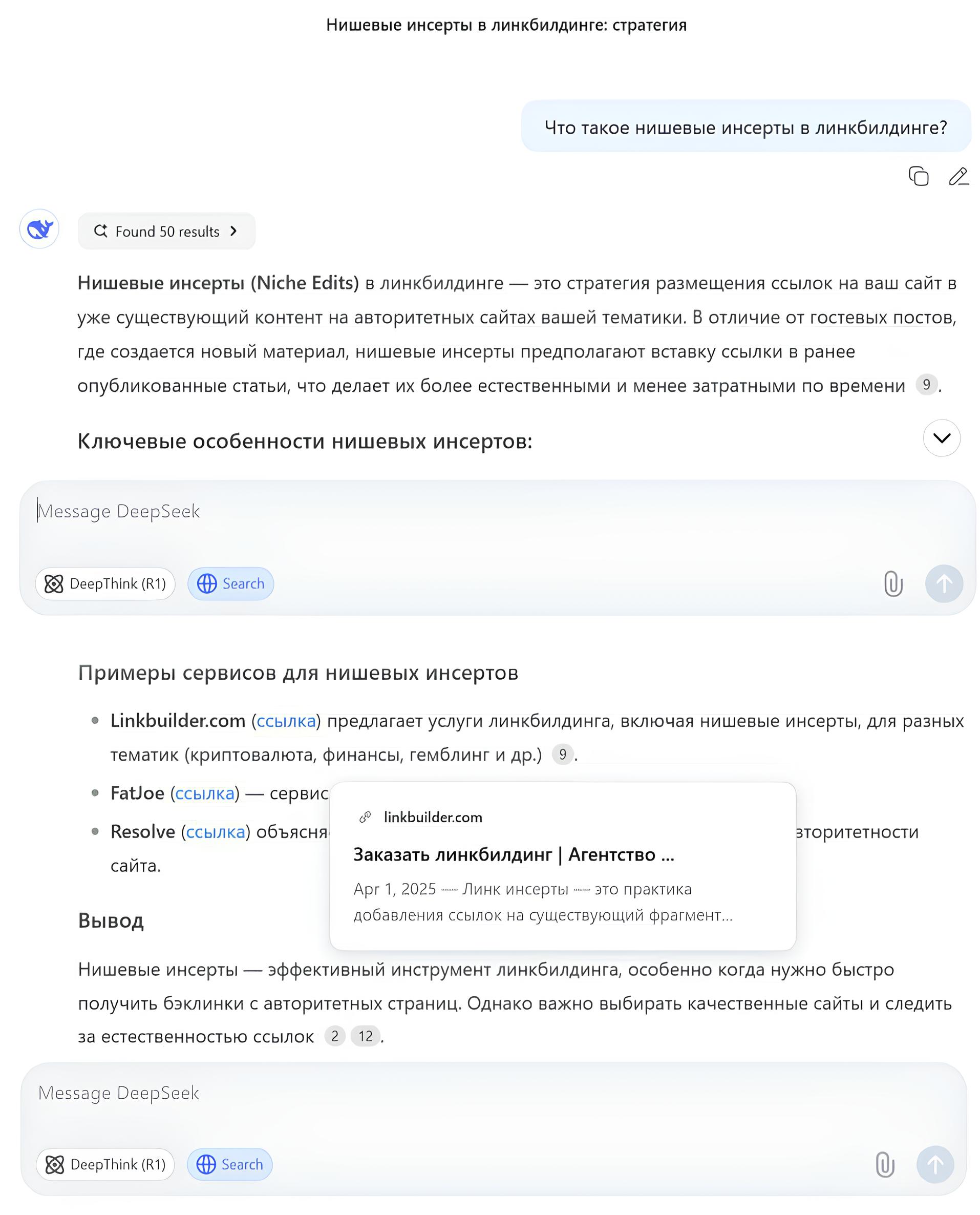

Практический способ проверки: задайте ключевые вопросы по вашей теме нескольким LLM (ChatGPT, Claude, Bard, DeepSeek) и сравните их ответы с вашим контентом. Если вы попадаете в ответы ИИ – это уже хороший знак.

Заодно проверьте, кто из конкурентов есть в ответах. Отметьте аспекты, которые модели считают важными, но которые отсутствуют в ваших материалах.

Инструменты для анализа:

- Инструмент для автоматического анализа видимости и рейтинга поиска – AI Ranker

- Текстовые анализаторы для оценки читабельности – Hemingway App, Readability

- SEO-инструменты для анализа семантического ядра и структуры – Ahrefs, Semrush

- Сервисы проверки уникальности – Copyscape, Plagiarism Checker

По результатам анализа составьте список материалов, требующих оптимизации, ранжируя их по потенциальной ценности для LLM и объему необходимых изменений.

Шаг 2: Оптимизация структуры и семантики материалов

Как изучить языковую модель и ее предпочтения? Через практическое применение рекомендаций по структуре и семантике.

Оптимизация структуры начинается с улучшения иерархии и организации информации:

- Внедрите четкую иерархию заголовков:

- H1 – основная тема (один на страницу)

- H2 – основные разделы темы

- H3 – подразделы внутри основных разделов

- H4 – пункты внутри подразделов (опционально)

- Трансформируйте длинные параграфы:

- Разбейте их на более короткие (до 3-5 предложений)

- Добавьте подзаголовки для логических блоков

- Преобразуйте перечисления в маркированные списки

- Внедрите структурные элементы:

- Блоки «Важно знать» или «Ключевые моменты»

- Секции FAQ с прямыми ответами на частые вопросы

- Резюме или заключения в конце сложных разделов

Семантическая оптимизация фокусируется на лексике и смысловых связях:

- Расширьте семантическое ядро:

- Включите синонимы ключевых терминов

- Добавьте связанные концепции и термины

- Используйте разные формулировки для объяснения важных понятий

- Усильте фактологическую базу:

- Добавьте конкретные цифры, статистику, даты

- Подкрепите утверждения ссылками на авторитетные источники

- Включите примеры из реальной практики

- Оптимизируйте читабельность:

- Используйте активный залог вместо пассивного

- Сократите длину предложений там, где это возможно

- Замените специализированные термины более доступными аналогами (с сохранением точности)

Техническая оптимизация для LLM также включает:

- Метаданные:

- Оптимизируйте title, description и alt-текст изображений

- Включайте ключевые термины в URL-структуру

- Используйте разметку Schema для структурированных данных

- Внутренняя связность:

- Добавьте перекрестные ссылки между связанными материалами

- Создайте глоссарии для специализированных терминов

- Разработайте подробное оглавление для объемных материалов

При оптимизации важно сохранять баланс – материал должен оставаться естественным и ценным для человека-читателя, не превращаясь в перенасыщенный ключевыми словами текст.

Шаг 3: Размещение контента на приоритетных для ИИ платформах

После оптимизации собственных материалов следующий этап – стратегическое размещение контента на внешних платформах. Следуйте этому плану:

- Определите приоритетные платформы в зависимости от вашей ниши. Подробный список вы найдете выше в статье.

- Адаптируйте контент под форматы каждой платформы, например:

- Для GitHub – создайте документацию в формате Markdown

- Для Medium – адаптируйте материал под лонгрид с визуальными элементами

- Для Quora – трансформируйте в формат развернутых ответов

- Создайте план публикаций с учетом:

- Периодичности размещения (регулярность важна для построения авторитета)

- Последовательности (начиная с наиболее авторитетных платформ)

- Сезонности и актуальности (приурочивайте публикации к событиям в отрасли)

- Усильте кросс-платформенное присутствие через:

- Ссылки между различными публикациями

- Единообразие терминологии и ключевых концепций

- Последовательное представление бренда

- Обеспечьте социальное подтверждение контента:

- Привлекайте комментарии и обсуждения

- Стимулируйте шеринг в социальных сетях

- Получайте поддержку от отраслевых экспертов

Посев контента – это не просто размещение материалов на разных площадках, а создание согласованной информационной экосистемы, где ваша экспертиза подтверждается из множества авторитетных источников. Именно такой подход максимизирует шансы на включение в обучающие данные LLM.

Для качественного размещения на ключевых платформах обратитесь в LinkBuilder.com – агентство, специализирующееся на стратегическом посеве контента для LLM. Наша команда поможет с:

- Размещением экспертных ответов на Quora

- Публикацией в HARO для цитирования в СМИ

- Участием в дискуссиях на Reddit и других профильных форумах

- Публикацией гостевых постов на авторитетных отраслевых ресурсах

Шаг 4: Регулярное обновление и расширение информации

Посев контента для LLM – не разовая акция, а непрерывный процесс. Система ценит свежую и обновляемую информацию, но обновляется периодически, а не в реальном времени.

Ключевые аспекты стратегии обновления:

Аудит устаревающей информации – регулярно проверяйте свой контент на предмет:

- Устаревших статистических данных

- Изменившихся технологий или методик

- Неактуальных примеров или кейсов

Рекомендуемая частота: ежеквартально для быстро меняющихся отраслей (технологии, маркетинг) и раз в полгода для более стабильных областей.

Актуализация контента должна включать:

- Обновление статистики и данных:

- Заменяйте старые цифры актуальными

- Добавляйте новые исследования и отчеты

- Указывайте даты обновления материала

- Расширение примеров и кейсов:

- Добавляйте новые успешные кейсы

- Обновляйте результаты ранее описанных примеров

- Включайте современные сценарии использования

- Отражение новых тенденций:

- Дополняйте материалы информацией о новых разработках

- Адаптируйте рекомендации к изменившимся условиям

- Комментируйте значимые события отрасли

Расширение семантического охвата помогает увеличить видимость в LLM:

- Добавление новых разделов по связанным темам

- Углубление существующих тем с большей детализацией

- Включение ответов на новые часто задаваемые вопросы

Поддержание кросс-платформенной согласованности требует:

- Синхронизации обновлений между собственным сайтом и внешними платформами

- Обновления ранее размещенных материалов на внешних ресурсах

- Создания новых материалов для отражения изменений и дополнений

Важный нюанс: модели обучаются на датасетах, собранных к определенному моменту времени. Поэтому обновления могут не сразу отразиться в ответах ИИ – для этого требуется новый цикл обучения или дообучения модели.

Практические рекомендации:

- Создавайте не только обновления, но и новые материалы на базе обновленной информации

- Используйте формулировки вроде «По состоянию на август 2025 года...» для четкой временной привязки

- Отмечайте обновленные материалы тегами «Обновлено» с датой

- Сохраняйте архивные версии для отслеживания изменений

Стратегия вечнозеленого контента с обновлениями – оптимальный подход, когда базовая информация остается актуальной, а статистика, примеры и тренды регулярно обновляются.

Шаг 5: Мониторинг индексации и корректировка стратегии

Заключительный этап процесса – это отслеживание результатов и адаптация стратегии. Методы мониторинга присутствия в LLM:

- Тестирование запросов – регулярно задавайте ключевые вопросы по вашей тематике разным языковым моделям или проверяйте их в AI Ranker.

- Отслеживание атрибуции – проверяйте, упоминается ли ваш бренд, продукт или эксперт в ответах на релевантные запросы.

- Анализ формулировок – обращайте внимание, используются ли в ответах ИИ уникальные фразы или термины из вашего контента.

- Мониторинг внешних ссылок – отслеживайте, когда на ваш контент ссылаются другие сайты, особенно авторитетные ресурсы.

Интерпретация результатов и корректировка стратегии включает в себя:

- Анализ успешных материалов:

- Какие темы чаще появляются в ответах LLM?

- Какие форматы контента показывают лучшие результаты?

- На каких платформах размещены наиболее цитируемые материалы?

- Выявление пробелов:

- По каким запросам ваш контент не появляется в ответах?

- Какие аспекты темы недостаточно освещены?

- Какие конкуренты чаще цитируются и почему?

- Корректировка стратегии:

- Усиление присутствия на эффективных платформах

- Изменение формата или структуры контента

- Расширение семантического ядра на основе анализа ответов

Важные метрики для оценки эффективности:

- Частота упоминаний – как часто ваш бренд/эксперт появляется в ответах

- Точность атрибуции – насколько корректно передается ваша информация

- Охват тем – по какому спектру запросов появляется ваш контент

- Конверсия – приводят ли упоминания в LLM к переходам на сайт (сложно отследить)

Помните, что стратегия посева контента для LLM – это марафон, а не спринт. Результаты накапливаются со временем, особенно при систематическом подходе и постоянном совершенствовании контента.

Будущее посева контента: тренды и прогнозы

Мир языковых моделей развивается стремительно, и стратегии посева контента должны эволюционировать вместе с ним. Основы LLM сегодняшнего дня могут существенно измениться завтра под влиянием новых технологических прорывов.

Влияние мультимодальных моделей (текст + изображения + видео) станет одним из определяющих факторов в ближайшие годы. Модели вроде GPT-4V, Gemini и Claude 3 уже умеют анализировать изображения, а скоро эти возможности расширятся на видео и аудио.

Что это означает для посева контента:

- Мультиформатный контент станет стандартом. Комбинация текста, изображений, инфографики и видео будет восприниматься LLM как более информативная и заслуживающая доверия.

- Визуальная оптимизация приобретет не меньшее значение, чем текстовая. Четкая структура визуальных элементов, подписи и альтернативные тексты станут критически важными.

- Аудиоконтент (подкасты, интервью) получит новую жизнь благодаря автоматической транскрипции и анализу речи, что позволит включать его в обучающие данные LLM.

Персонализация ответов ИИ открывает новые возможности для маркетологов. По мере того, как LLM учатся адаптировать ответы под конкретного пользователя, создатели контента смогут:

- Таргетировать различные аудитории через специализированный контент для разных демографических и психографических групп.

- Создавать многоуровневые материалы с различной глубиной для начинающих и продвинутых пользователей.

- Адаптировать тон и стиль под различные сценарии использования – от обучения до развлечения.

Обучение и обновление моделей в реальном времени, вероятно, станет новой нормой. В отличие от LLM с фиксированной базой знаний, будущие модели смогут обновляться в режиме реального времени. Это повысит ценность:

- Новостного контента и актуальных данных

- Оперативных комментариев к событиям отрасли

- Регулярно обновляемых ресурсов

Верификация источников станет более значимой. По мере роста обеспокоенности достоверностью информации, LLM будут отдавать предпочтение контенту, который:

- Подтвержден независимыми источниками

- Опубликован авторами с проверяемой экспертизой

- Содержит ссылки на первоисточники

Локализация и культурный контекст приобретут большее значение. Следующие поколения больших языковых моделей будут лучше учитывать географические и культурные особенности. Для стратегий посева это означает важность:

- Регионально-специфичного контента

- Учета культурных нюансов

- Многоязычного представления информации

Интеграция с другими технологиями создаст новые возможности для посева. LLM станут частью более сложных экосистем, включающих:

- Интернет вещей – для контекстуализации информации

- Дополненную реальность – для визуализации данных

- Блокчейн – для верификации авторства и происхождения контента

Этические стандарты и регулирование будут усиливаться. В ответ на растущие опасения по поводу дезинформации и манипуляций, разработчики LLM и регуляторы будут внедрять более строгие стандарты для контента. Это потребует:

- Большей прозрачности в создании и распространении информации

- Систем сертификации контента для критически важных областей

- Четкого разделения между фактами и мнениями

Как посеять контент для ИИ с учетом будущих тенденций? Фокусируйтесь на создании мультиформатного, фактически точного контента с высокой экспертной ценностью, который легко верифицировать. Такой подход обеспечит долгосрочную устойчивость вашей стратегии посева контента независимо от конкретных технологических изменений.